La nueva edición de nuestro especial Tendencias Tecnológicas vuelve a poner de manifiesto la relevancia de la inteligencia artificial (IA), que se consolida como protagonista indiscutible de la presente publicación. Esta posición preeminente obedece al ritmo vertiginoso con que la IA expande su radio de alcance en el ecosistema tecnológico, patente en el surgimiento de nuevas soluciones —como agentes inteligentes, orquestación y automatización de procesos con IA, robótica avanzada, servicios en la nube potenciados por IA, entre otros—. En conjunto, estos avances afianzan su papel como pilar estratégico y transversal en las iniciativas de transformación digital de las organizaciones a escala global.

No obstante, la rápida evolución de la IA contrasta con el desafío que supone para un gran número de organizaciones alinear su uso real con las expectativas del mercado. Según señala la firma analista McKinsey en The state of AI in 2025: Agents, innovation, and transformation, aunque las herramientas de IA son ahora comunes, “la mayoría de las organizaciones aún no las han integrado lo suficiente en sus flujos de trabajo y procesos como para obtener beneficios sustanciales a nivel empresarial”. A esto se suma que, para la mayoría de las empresas “el uso de la IA todavía se encuentra en fase de experimentación o prueba piloto”. De hecho, casi dos tercios de los directivos encuestados por la consultora afirman que “sus empresas aún no han comenzado a ampliar la implementación de la IA a lo largo de toda la organización”.

Más allá de la IA y de las innovaciones que surgen fruto de la sinergia con otras tecnologías, se prevé que nuevas tendencias dominen el escenario empresarial en 2026, entre ellas la computación cuántica. A este respecto, conviene destacar que el Massachusetts Institute of Technology (MIT) ha puesto en marcha un ambicioso proyecto interdisciplinario que aplica avances cuánticos en ciencia, tecnología, industria y seguridad nacional. Bajo el nombre de QMIT, esta iniciativa, con sede física en el campus del MIT, reúne a investigadores, estudiantes y empresas interesadas en explorar aplicaciones cuánticas de alto impacto, con el propósito de desarrollar soluciones prácticas en computación, sensores, redes, simulaciones y algoritmos.

Ante este contexto de continua evolución tecnológica, si su organización está evaluando nuevas inversiones en transformación digital para mejorar la competitividad, impulsar la innovación y promover la sostenibilidad, le invitamos a consultar esta publicación. Un documento revisado de manera anual y que proporciona un análisis completo y experto sobre las tendencias tecnológicas estratégicas con mayor proyección en 2026.

Tendencia tecnológica 1: Servicios en la nube con lA

Tendencia tecnológica 1: Servicios en la nube con lA

La adopción de la IA integrada en los servicios en la nube está llamada a transformar la manera en que las empresas gestionan las operaciones de Tecnologías de la Información (TI). Esta integración supone que la IA deja de tener un rol secundario, para convertirse en un componente central, presente desde la gestión de la infraestructura hasta el despliegue de aplicaciones.

Los servicios en la nube con IA integrada representan la incorporación de capacidades de IA en la infraestructura y las plataformas de nube, proporcionando la base tecnológica necesaria para desarrollar aplicaciones y procesos más inteligentes. Según Gartner, en AI-Enabling Cloud Services are the Future of Cloud, “para 2030, más del 80 % de las empresas desplegarán agentes de IA específicos para su sector en apoyo de objetivos críticos del negocio, frente a menos del 10 % actual, y más del 60 % de las empresas realizarán actividades intensivas de IA en varias nubes”.

A partir de esta base tecnológica surgen las soluciones de nube industrial potenciadas por IA, que suponen un enfoque más especializado y sectorial. Estas soluciones combinan IA, datos y análisis para optimizar procesos críticos en industrias específicas. En otras palabras, mientras la IA integrada en la nube proporciona la infraestructura y las capacidades generales, las soluciones de nube industrial aplican estas capacidades de manera directa a procesos y problemas específicos del negocio.

Gartner también advierte sobre la importancia de optimizar la infraestructura subyacente, es decir, los recursos tecnológicos y de computación necesarios para ejecutar los sistemas de IA —servidores, plataformas de software, almacenamiento y redes que soportan estas cargas de trabajo—. Según la firma con sede en Stamford, las empresas que no optimicen la infraestructura “desembolsarán más de un 50 % adicional en comparación con aquellas que sí lo hagan”.

A esta cuestión se suma la demanda energética asociada a las cargas de trabajo de IA que, según Gartner, “podría triplicarse para 2030, lo que conlleva una revisión integral de la infraestructura de energía y refrigeración de los centros de datos”.

Otro aspecto crítico en las estrategias en la nube es la “soberanía digital”, referida al control sobre los datos, las operaciones y la tecnología, y que adquiere un creciente protagonismo ante las tensiones geopolíticas y los cambios regulatorios. A este respecto, Gartner recomienda, como medidas para abordar los retos relacionados con la soberanía digital definir los requerimientos —a nivel técnico, operativo y de datos—, evaluar las opciones de alojamiento, interactuar con proveedores y garantizar que las estrategias en la nube sean flexibles para adaptarse al contexto geopolítico y normativo.

Tendencia tecnológica 2: Servicio como producto, la transformación modular de los servicios de TI

Tendencia tecnológica 2: Servicio como producto, la transformación modular de los servicios de TI

La firma IDC estima que para 2029, “el 30 % de los servicios globales de TI se comercializarán como productos modulares habilitados mediante plataformas, impulsados por la demanda de las empresas de velocidad, transparencia, IA generativa y la orquestación de servicios autónomos habilitada por agentes de IA”. Así lo recoge el informe IDC FutureScape: Worldwide IT Industry 2026, que señala que esta tendencia refleja una transformación profunda en la forma en que los servicios se diseñan, consumen y escalan, obligando a los proveedores a adoptar prácticas de gestión de producto y a explorar nuevos modelos comerciales, como la suscripción o los precios basados en resultados.

Las empresas buscan cada vez más compromisos de servicio orientados a resultados que simplifiquen la complejidad y aceleren la obtención de valor. Los componentes de servicio modulares, suministrados a través de plataformas, garantizan resultados consistentes, flexibilidad de integración con otros sistemas y gobernanza a gran escala.

Con la finalidad de capitalizar las oportunidades que ofrece esta tendencia tecnológica, IDC recomienda a los CIO que evalúen la madurez de los proveedores en términos de AI assurance —capacidad para garantizar que los sistemas de IA sean confiables, seguros y cumplan con normativas y estándares—, así como las herramientas de orquestación y posibilidades de integración que ofrecen, con el fin de evitar entregas fragmentadas y minimizar riesgos de incumplimiento.

En el caso de aquellas organizaciones que enfrentan dificultades para medir y materializar el valor de este tipo de inversiones, IDC aconseja “la adopción de prácticas sólidas de realización de valor”, es decir, disponer de marcos, procesos, métricas y modelos de gobernanza para evaluar el impacto generado, supervisar el progreso y garantizar que las inversiones tecnológicas se traduzcan en resultados tangibles.

La transición hacia modelos en donde los servicios se conciben como productos exige una revisión profunda de los esquemas de entrega por parte de las firmas de servicios de TI. El éxito está condicionado por la capacidad de ofrecer servicios habilitados por plataformas que sean modulares, escalables y cuenten con mecanismos de gobernanza integrada que aseguren control, cumplimiento y operación confiable, incorporando propiedad intelectual específica de la industria, fomentando la innovación colaborativa y posibilitando configuraciones de servicio adaptativas.

IDC concluye que la provisión de servicios como producto se convertirá en un imperativo estratégico, tanto para compradores como proveedores, guiando la próxima ola de transformación empresarial impulsada por la IA.

Tendencia tecnológica 3: IA Agentiva

Tendencia tecnológica 3: IA Agentiva

La IA agentiva, también conocida como IA basada en agentes, se ha consolidado como una de las principales tendencias tecnológicas en 2025 y continúa con trayectoria ascendente en 2026. Esta tecnología se fundamenta en sistemas autónomos capaces de tomar decisiones, establecer objetivos y ejecutar estrategias complejas, sin supervisión humana continua. De esta forma, la IA agentiva transforma la interacción entre personas y máquinas, y amplía las capacidades para gestionar operaciones empresariales, al posibilitar que los sistemas asuman responsabilidades operativas de manera independiente.

A diferencia de los sistemas tradicionales de IA, que se limitan al reconocimiento de patrones y análisis predictivo, los agentes de IA comprenden el contexto y adaptan las estrategias conforme evolucionan las situaciones. Además de responder a instrucciones como lo hace un sistema tradicional, identifican oportunidades, definen objetivos y coordinan los recursos necesarios para alcanzarlos. Además, estos agentes pueden trabajar de forma colaborativa, de modo que cada uno se enfoca en una tarea específica y, al combinarse entre sí, conforman redes inteligentes capaces de resolver problemas complejos y dinámicos.

Los agentes de IA representan una evolución significativa en la IA aplicada a nivel empresarial, porque allanan el camino para la transición “de una IA reactiva hacia un colaborador virtual proactivo”, según detalla McKinsey en Seizing the agentic AI advantage. Como resultado, los agentes abren una vía para superar lo que desde la consultora denominan “paradoja de la IA generativa”, un concepto que explica cómo un gran número de empresas adoptan tecnologías de IA de última generación sin que estas generen un impacto notable en los resultados o desempeño comercial.

Para superar esta paradoja, McKinsey explica que los agentes de IA tienen el potencial de automatizar procesos empresariales complejos, al combinar autonomía, planificación, memoria e integración. Así, la IA trasciende su carácter reactivo y se transforma en un asistente virtual autónomo con capacidades de planificación y orientado a la consecución de resultados.

No obstante, para maximizar el potencial de la IA agentiva se requiere más que integrarla en los flujos de trabajo —conjunto de actividades y tareas que se realizan de manera secuencial y que implican colaboración, intercambio de información y toma de decisiones para alcanzar un objetivo específico—; hay que ir un paso más allá y rediseñarlos desde cero, situando a los agentes como elementos centrales del proceso.

En cuanto al nivel de implementación empresarial, según datos de McKinsey recogidos del informe The state of AI in 2025: Agents, innovation, and transformation, en la actualidad, el 23 % de las organizaciones está escalando agentes de IA en al menos un área específica de actividad, mientras que un 39 % se encuentra en fase de experimentación. A pesar de estos avances, la adopción sigue siendo limitada, ya que la mayoría de los despliegues se concentran en una o dos áreas, y en cualquier área concreta no más del 10 % de las organizaciones han escalado agentes de IA.

Tendencia tecnológica 4: Automatización de procesos con IA

Tendencia tecnológica 4: Automatización de procesos con IA

La denominada “paradoja de la IA”, mencionada en el apartado anterior de este especial de tendencias tecnológicas, describe aquella situación en la que numerosas empresas adoptan tecnologías avanzadas de IA, sin que ello se traduzca en mejoras significativas en los resultados o en el desempeño comercial.

Esto implica que, aunque la IA esté implantada, el potencial transformador del que dispone no siempre se materializa en beneficios tangibles. McKinsey vincula esta paradoja a un desequilibrio entre los casos de uso horizontales y verticales de aplicación general de la IA. De tal forma que, mientras los primeros se adoptan de forma generalizada, los segundos —con mayor potencial de impacto económico— permanecen, en muchos casos, en fases iniciales de desarrollo.

Por un lado, los casos de uso horizontales, como copilots y chatbots empresariales, se han adoptado de forma masiva. Un ejemplo de ello es Microsoft 365 Copilot, utilizado por casi el 70 % de las compañías Fortune 500, según datos de McKinsey. Estas herramientas están orientadas a mejorar la productividad individual, al ahorrar tiempo en tareas rutinarias y facilitar la gestión y síntesis de información. Sin embargo, los beneficios generados se diluyen entre los empleados, lo que dificulta que se traduzcan en resultados globales para la empresa.

Por otro lado, los casos de uso verticales, vinculados a áreas de actividad específicas y procesos empresariales concretos, han experimentado un escalamiento limitado en la mayoría de las empresas. Según McKinsey, menos del 10 % de estos casos de uso supera la fase piloto e, incluso, cuando llegan a implementarse suelen centrase en la automatización de tareas aisladas dentro de un proceso y funcionan de manera reactiva. Como resultado, su contribución a la eficiencia operativa y a la mejora del desempeño empresarial es limitada, y no alcanza el potencial transformador que la IA podría ofrecer a nivel estructural.

Este desequilibrio entre las tipologías de casos de uso se justifica, en parte, por la facilidad de implementación de las soluciones horizontales, como Microsoft Copilot o Google AI Workspace, que no requieren reconfigurar los flujos de trabajo ni esfuerzos significativos de gestión del cambio organizacional. Además, la rápida adopción de chatbots internos ha estado motivada por la necesidad de proteger la información sensible y garantizar el cumplimiento de políticas corporativas.

El verdadero avance, según explica McKinsey, se produce con la automatización de flujos de trabajo complejos mediante agentes de IA, que amplían la capacidad de los LLM tradicionales, pasando de generar contenido de manera reactiva a ejecutar tareas de forma autónoma y orientada a objetivos. A diferencia de los LLM, que operan de forma aislada y carecen de memoria contextual entre sesiones, estos agentes integran componentes tecnológicos adicionales que aportan memoria, planificación, integración y orquestación. Esto les permite comprender objetivos, desglosarlos en subtareas, interactuar con sistemas y personas, ejecutar acciones y adaptarse en tiempo real con mínima intervención humana.

Al combinar estas capacidades, los copilots de propósito general evolucionan de asistentes reactivos a colaboradores proactivos, capaces de supervisar paneles, activar flujos de trabajo, hacer seguimiento de tareas y proporcionar información relevante en tiempo real. No obstante, el impacto más significativo se produce a nivel vertical, donde la IA agentiva posibilita la automatización de procesos empresariales complejos que abarcan múltiples pasos, actores y sistemas, convirtiendo la IA en un motor estratégico capaz de generar resultados tangibles y sostenibles.

Tendencia tecnológica 5: Tecnología sostenible

Tendencia tecnológica 5: Tecnología sostenible

La tecnología sostenible es un concepto que engloba todas aquellas soluciones orientadas a preservar los principios de protección ambiental y garantizar un uso responsable de los recursos, minimizando el impacto ecológico. Las soluciones bajo este paraguas posibilitan que empresas e instituciones puedan optimizar los procesos, reducir la huella ambiental y orientar la planificación estratégica en base a criterios de gestión responsable.

En 2026, se anticipan cambios significativos impulsados por diversas iniciativas tanto en servicios tecnológicos como en el desarrollo de soluciones más respetuosas con el medio ambiente, que influyen de manera directa en la planificación, adopción y gestión tecnológica empresarial.

- IA para la sostenibilidad: El artículo Artificial intelligence for sustainability, recogido en la revista Discover Conservation, elaborado por dos profesionales del Stockholm Environment Institute (SEI), Julia Barrot y Matthew Fielding, analiza el papel de la IA y las tecnologías de Observación de la Tierra (OT) para la gestión sostenible de los bosques y la mitigación del cambio climático. En concreto, la combinación de estas dos tecnologías sirve para monitorizar, mapear e interpretar ecosistemas forestales a escalas temporales y espaciales que serían inalcanzables con métodos tradicionales. En cuanto a las aplicaciones más relevantes destacan la predicción y el seguimiento de incendios forestales, la evaluación de cambios ambientales a gran escala, la detección de tala ilegal y la planificación de la gestión forestal sostenible. No obstante, el uso de IA y OT de forma combinada conlleva ciertos desafíos, incluyendo sesgos algorítmicos, limitaciones de calidad de datos, falta de transparencia y desigualdades en el acceso a la tecnología. Con la finalidad de maximizar los beneficios y reducir riesgos, resulta fundamental establecer directrices éticas, mecanismos de gobernanza sólidos y supervisión humana, así como integrar conocimientos tradicionales y fomentar la cooperación internacional. Así, la combinación de IA y OT se configura como un recurso estratégico para apoyar la conservación forestal, proteger la biodiversidad y reforzar la resiliencia climática global.

- Informática verde y descarbonización: Se trata de dos elementos que juegan un papel muy importante en las estrategias de sostenibilidad. Con el compromiso de reducir las emisiones de carbono, las empresas, incorporan tecnologías de alta eficiencia energética como los centros de datos sostenibles y la adopción del modelo edge computing —que optimiza el uso de recursos energéticos al procesar los datos cerca del origen, mejorando el rendimiento, reduciendo la latencia y limitando el traslado de datos a infraestructuras centralizadas—. En consecuencia, las organizaciones logran reducir la huella de carbono, optimizar costes y avanzar hacia un modelo más sostenible. Según recoge el IDC FutureScape: Worldwide IT Industry 2025 Predictions “para 2026, el 60 % de las empresas implementarán marcos de IA sostenibles, aprovechando decisiones basadas en datos para escalar las operaciones de IA en las ubicaciones de los centros de datos, al tiempo que cumplen con los objetivos de descarbonización”.

- Eficiencia de recursos y circularidad: Las organizaciones buscan optimizar el uso de recursos, reducir residuos y prolongar la vida útil de los productos mediante un diseño más sostenible. En esta línea, destacan ejemplos como el de Microsoft que ha superado el objetivo interno de reutilización y reciclaje de servidores y componentes, alcanzando el 90,9 %. Otro ejemplo es Apple que, en su informe de progreso medioambiental anual, señala que en 2025 ha reducido en más de un 60 % las emisiones globales de gases de efecto invernadero, con el objetivo de alcanzar la neutralidad de carbono en la huella medioambiental para 2030. Por su parte, Siemens ha disminuido la huella operativa en un 66 % desde 2019 (sin créditos de carbono), avanzando hacia la meta de reducir un 90 % las emisiones de alcance 1 y 2 al inicio de la nueva década.

Tendencia tecnológica 6: Computación cuántica

Tendencia tecnológica 6: Computación cuántica

Para entender la computación cuántica, resulta necesario echar la mirada atrás y realizar un breve repaso a su historia. Para ello, es necesario retrotraerse a la conferencia «Physics of Computation» organizada por el MIT e IBM, en 1981, donde el físico Richard Feynman pronuncia un discurso memorable del que rescatamos el siguiente extracto: “Nature is quantum, goddamn it! So, if we want to simulate it, we need a quantum computer”.

Con esta frase, el premio Nobel de Física, alude a que la naturaleza, y el universo en su conjunto, funcionan según las leyes de la mecánica cuántica. Esto significa que los fenómenos del mundo físico —relacionados con el comportamiento de partículas subatómicas, átomos y moléculas—, no pueden ser simulados con precisión usando ordenadores clásicos, ya que estos se basan en lógica binaria y determinista, muy distinta de la lógica probabilística del mundo cuántico. Por ello, para simular de forma fiel el funcionamiento del universo a escala microscópica es necesario disponer de ordenadores que, también, operen bajo los principios cuánticos como la superposición, el entrelazamiento y la interferencia.

Poco tiempo después del discurso de Feynman, se ponen en marcha diversas líneas de investigación que, durante la década de los noventa, dan como resultado dos algoritmos que demuestran la aplicabilidad práctica de la computación cuántica y marcan el punto de partida para el desarrollo de los ordenadores cuánticos. El de tipo universal, como el basado en compuertas de IBM con 1.121 qubits y el especializado en quantum annealing, como el de D-Wave con 5.000 qubits.

En el periodo reciente ha habido avances significativos en algoritmos y software cuántico, al tiempo que se multiplican los esfuerzos por construir computadoras cuánticas a gran escala, con la participación de empresas como Google, Honeywell, Intel, Microsoft, Origin Quantum, QUDOOR, ZTE, entre otras.

Este recorrido permite entender mejor la diferencia entre la computación tradicional y la computación cuántica. La primera se basa en bits que solo pueden asumir dos posibles valores: ‘0’ o ‘1’, para almacenar y procesar datos. En cambio, en la computación cuántica, la unidad básica es el qubit —bit cuántico— que, según la física cuántica, puede tener un valor de ‘0’ o ‘1’, o encontrarse en superposición de ambos estados. Esta propiedad dota a los sistemas de computación cuántica de un espacio de cálculo de gran dimensión, conocido como espacio de Hilbert, donde 𝑛 qubits pueden representar 2^𝑛 valores posibles de manera simultánea.

En la práctica, esta tendencia tecnológica tiene el potencial de transformar un gran número de sectores. A nivel farmacéutico, acelerando el descubrimiento de nuevos fármacos, por medio de la simulación molecular de alta precisión. En el sector energético, contribuyendo al avance de la fusión nuclear para generar energía 100 % limpia e ilimitada. También, ofrece la posibilidad de resolver problemas hasta ahora sin respuesta, como la simulación de sistemas cuánticos complejos o la optimización combinatoria a gran escala. Asimismo, abre la puerta a avances científicos relacionados con la mecánica cuántica o el desarrollo de nuevas tecnologías derivadas como la criptografía cuántica.

No obstante, el desarrollo de la computación cuántica a gran escala plantea importantes desafíos como se describe en el capítulo «Quantum Computing: Vision and Challenges», del libro Quantum Computing: Principles and Paradigms, de Morgan Kaufmann. El más difícil de mitigar es la decoherencia de los estados cuánticos en los que se codifican los qubits. La decoherencia se produce cuando los qubits interactúan con su entorno —es decir, con todo aquello que los rodea y puede afectar su estado cuántico, como vibraciones o movimientos microscópicos del material que los sostiene, campos electromagnéticos externos, variaciones de temperatura, radiación, partículas subatómicas o componentes de hardware aislados de forma inadecuada—, provocando la pérdida de propiedades cuánticas y, en consecuencia, la degradación de la información. Este fenómeno constituye uno de los principales obstáculos para la construcción de dispositivos cuánticos escalables, ya que el ruido ambiental es inevitable incluso en entornos altamente controlados.

Los dispositivos conocidos como Noisy Intermediate-Scale Quantum (NISQ), representan una etapa intermedia en la evolución de la computación cuántica. Estos cuentan con un número limitado de qubits y están sujetos a errores y perturbaciones causadas por la decoherencia. A pesar de estas limitaciones, los NISQ realizan cálculos trabajando con los qubits disponibles y tolerando cierta cantidad de ruido. Por consiguiente, los esfuerzos en computación cuántica se centran en dos objetivos: reducir la probabilidad de que los qubits pierdan coherencia y desarrollar métodos eficaces de corrección de errores que compensen la pérdida de información.

Además de los desafíos relacionados con la decoherencia, los dispositivos cuánticos modernos afrontan la complejidad de diseñar e interconectar qubits de manera eficiente, garantizando el entrelazamiento cuántico. En la actualidad, la conectividad entre qubits es limitada, lo que dificulta realizar cálculos avanzados que requieren múltiples interacciones simultáneas. Esto supone un obstáculo para la ejecución de algoritmos cuánticos y subraya la necesidad de avanzar en nuevas arquitecturas y estrategias de entrelazamiento que faciliten la escalabilidad y el rendimiento de los sistemas cuánticos.

Por último, en lo que respecta al impacto económico del mercado de la computación cuántica, Boston Consulting Group (BSC) señala en The Long-Term Forecast for Quantum Computing Still Looks Brigh que esta tendencia “creará entre 450 y 850 mil millones de dólares de valor económico a nivel mundial, con un mercado para proveedores de hardware y software de entre 90 y 170 mil millones de dólares para 2040”.

Por su parte, el Quantum Technology Monitor de McKinsey señala que “los tres pilares fundamentales de la tecnología cuántica —computación, comunicación y detección cuánticas— podrían generar, en conjunto, hasta 97.000 millones de dólares en ingresos a nivel mundial para 2035. La computación cuántica captará la mayor parte de estos ingresos, pasando de 4.000 millones de dólares en 2024 a 72.000 millones de dólares en 2035”.

Tendencia tecnológica 7: Criptografía poscuántica

Tendencia tecnológica 7: Criptografía poscuántica

El desarrollo de la computación cuántica, que abordamos en el apartado anterior de este especial sobre tendencias tecnológicas, guarda una estrecha relación con el cambio criptográfico que se avecina. Dicho avance representa una amenaza para los estándares de cifrado actuales como, por ejemplo, RSA y ECC.

Para dimensionar la magnitud del riesgo, conviene recordar que la mayoría de los esquemas de cifrado actuales se fundamentan en problemas matemáticos complejos y de difícil resolución para un ordenador clásico. Sin embargo, es cuestión de tiempo que los ordenadores cuánticos puedan resolver estos problemas en minutos, lo que supone un grave peligro para la seguridad, tanto a nivel gubernamental como empresarial.

Según el informe Trends in Cibersecurity de Capgemini, aunque resulta difícil predecir cuándo los computadores cuánticos serán lo suficientemente avanzados para amenazar la ciberseguridad, las predicciones actuales de los expertos sobre la relevancia criptográfica de la computación cuántica (CRQC) se sitúan entre 2029 y 2035”. De hecho, se estima que los computadores cuánticos podrán comprometer el cifrado RSA con una probabilidad del 5 al 14 % en los próximos cinco años, una cifra que aumenta del 36 al 59 % en la próxima década.

Ante estas previsiones, la estrategia conocida como “cosechar hoy, descifrar después” —en inglés “harvest now, decrypt later”—, está siendo adoptada por actores maliciosos, con la finalidad de recabar datos cifrados de forma anticipada, para descifrarlos cuando las capacidades de la computación cuántica alcancen un nivel de madurez suficiente.

La preocupación por la seguridad ante la computación cuántica ha impulsado acciones a nivel gubernamental, institucional y empresarial, entre las cuales cabe destacar:

- El National Institute of Standards and Technology (NIST) en EE. UU. ha desarrollado algoritmos resistentes y estandarizados a ataques cuánticos, como CRYSTALS-Kyber, CRYSTALS-Dilithium, SPHINCS+ y FALCON, y está previsto que continúe desarrollando nuevos algoritmos durante los próximos años.

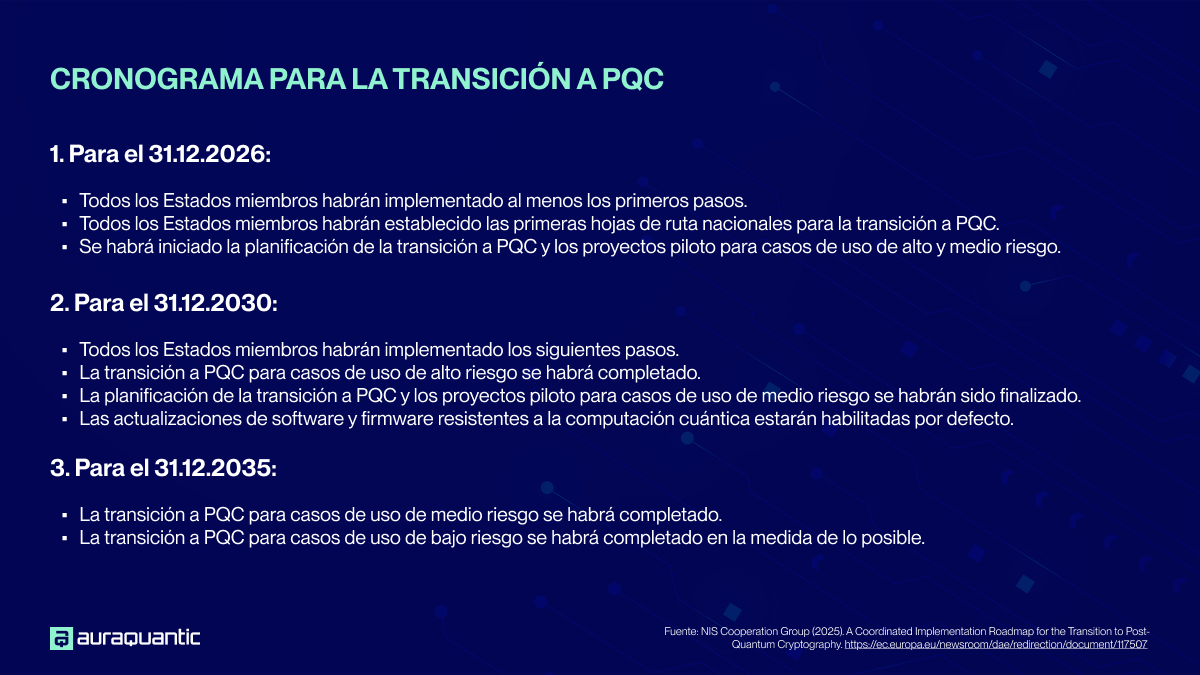

- Por su parte, la Unión Europea (UE) ha publicado la hoja de ruta para una transición coordinada hacia la criptografía poscuántica (PQC). Según este plan, todos los Estados miembros deben implementar al menos los primeros pasos y definir las hojas de ruta nacionales para 2026, iniciar la planificación de la transición a PQC y los pilotos para casos de alto y medio riesgo; completar la transición para casos de alto riesgo y finalizar los pilotos de medio riesgo para 2030; y, como último paso, lograr una implementación integral, incluyendo los casos de bajo riesgo, antes de 2035.

- A nivel empresarial, la computación cuántica también supone una amenaza para la seguridad de los datos y las comunicaciones sensibles. Las estimaciones actuales indican que la transición hacia PQC es un proceso prolongado, que requiere varios años, dado que los nuevos algoritmos exigen adaptaciones, tanto a nivel de infraestructura de hardware como de software, además de un mayor consumo de recursos computacionales.

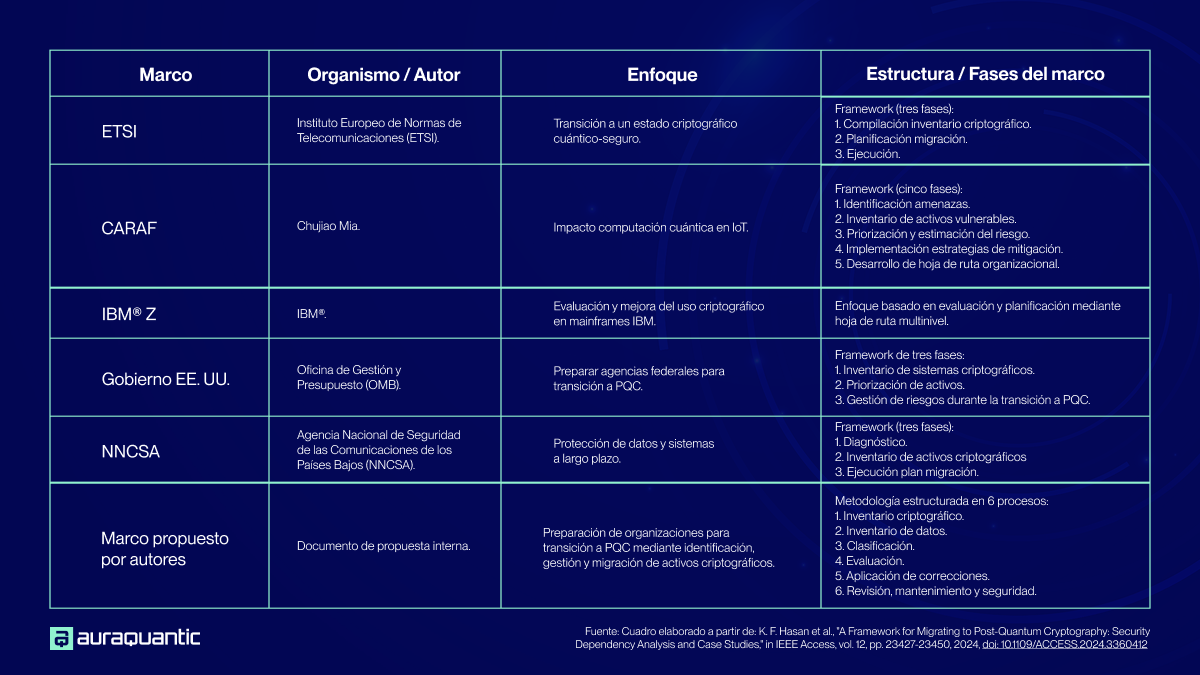

Para estructurar la transición a PQC, nuestro especial de tendencias tecnológicas toma como referencia la publicación A Framework for Migrating to Post‑Quantum Cryptography: Security Dependency Analysis and Case Studies, respaldada por el Cyber Security Research Centre Ltd., entidad financiada por el Cooperative Research Centres Program del Gobierno de Australia, y la colaboración de especialistas del ámbito académico y de la ciberseguridad.

El estudio identifica cinco marcos para abordar la migración a PQC, a los que se añade una propuesta metodológica desarrollada por los propios autores del estudio. Esta última, proporciona a las organizaciones una guía estructurada para identificar, administrar y trasladar los activos criptográficos, evaluar dependencias, planificar la adopción de algoritmos avanzados y ejecutar una migración progresiva, controlada y segura hacia esquemas criptográficos resistentes a la computación cuántica.

En términos generales, un marco de migración a PQC se define como un enfoque sistemático para reemplazar los activos criptográficos tradicionales, por alternativas resistentes a la computación cuántica. Esto incluye:

- Identificar, clasificar y registrar los activos criptográficos, incluyendo primitivas criptográficas, claves de cifrado, certificados digitales y componentes relacionados.

- Gestión integral del ciclo de vida de dichos activos, abarcando generación, distribución, almacenamiento, rotación y retirada de forma segura.

A continuación, se presentan los marcos de referencia analizados en el estudio, junto con las fases principales de cada propuesta:

Tendencia tecnológica 8: Robots impulsados por IA física

Tendencia tecnológica 8: Robots impulsados por IA física

En 2025, la robótica entra en una fase de evolución determinante, propiciada por los rápidos avances tecnológicos y la convergencia de IA, sensores avanzados y edge computing, así como por el auge del desarrollo de código abierto y la creciente disponibilidad de componentes de fabricación a menor coste.

En consonancia con este escenario de dinamismo tecnológico, los robots impulsados por IA han dejado de ser una tecnología limitada a entornos experimentales, para incorporarse a la realidad empresarial con aplicaciones operativas en ámbitos dispares.

Esta nueva generación de robots supone un salto cualitativo respecto a la robótica tradicional, caracterizada por la ejecución de tareas predefinidas. Esto es gracias a la IA física, que engloba sistemas de IA diseñados para percibir, interpretar y actuar sobre el mundo físico de manera autónoma. Al combinar datos sensoriales, comprensión espacial y toma de decisiones en tiempo real, estos sistemas pueden interactuar con entornos tridimensionales sujetos a leyes físicas.

A diferencia de la IA tradicional, dirigida exclusivamente a entornos digitales, la IA física dota a las máquinas de capacidad para comprender el entorno, aprender de la experiencia y adaptar su comportamiento en función de información dinámica.

El desarrollo de sistemas basados en IA física se sustenta en tecnologías como gráficos neuronales, generación de datos sintéticos, simulación basada en la física y modelos avanzados de razonamiento. De igual modo, por medio de métodos de entrenamiento como el aprendizaje por refuerzo y la imitación, estos sistemas adquieren, en entornos virtuales, nociones sobre principios y dinámicas físicas esenciales antes de ser desplegados en entonos reales.

En cuanto a las aplicaciones prácticas de esta tecnología, sobresalen ejemplos como el robot quirúrgico Da Vinci de Intuitive Surgical, que asiste en cirugías de alta precisión y aprende de patrones clínicos para optimizar los resultados. En robótica avanzada, destaca la nueva generación de Atlas® desarrollada por Boston Dynamics, un robot bípedo que integra IA para perfeccionar el movimiento y la manipulación de objetos. Por su parte, Tesla Optimus, aún en fase de desarrollo, se basa en sistemas de IA avanzados inspirados en la tecnología de los vehículos autónomos de Tesla, incluyendo algoritmos de aprendizaje automático para visión en tiempo real, reconocimiento de objetos y navegación autónoma.

A pesar de los notables avances de la robótica impulsada por IA, la adopción de esta tecnología enfrenta retos significativos en materia de regulación, gestión de datos y ciberseguridad. En relación con el impacto previsto sobre el futuro del trabajo, las iniciativas más exitosas son aquellas que promueven un modelo colaborativo humano-máquina, que permite automatizar tareas repetitivas y de alta precisión, detectar errores y reducir riesgos en el entorno laboral. Este enfoque sitúa a los profesionales en roles de supervisión, toma de decisiones y resolución de problemas complejos, mientras los robots se encargan de tareas técnicas y operativas. Para lograr una integración efectiva, las organizaciones deben redefinir roles, procesos y programas de capacitación, garantizando que humanos y robots trabajen de manera coordinada y complementaria.

En lo que concierne a las previsiones de crecimiento del mercado global de robots con IA, el informe Artificial Intelligence Robots Market de KBV Research estima que alcance los 37.900 millones de dólares en 2027, con una tasa de crecimiento anual compuesta (CAGR) del 32,3 %, durante el periodo 2021-2027. Esta evolución se ve respaldada por las estimaciones de Statista, que anticipa que el mercado de robótica industrial con IA alcance los 65.020 millones de dólares en 2030.