Las 5 Vs del Big Data

Las 5 Vs del Big Data son los pilares fundamentales sobre los que se asienta un concepto que va más allá del simple procesamiento y recopilación sistemática de conjuntos de datos, demasiado grandes o difíciles de manejar, para un software tradicional de procesamiento de datos.

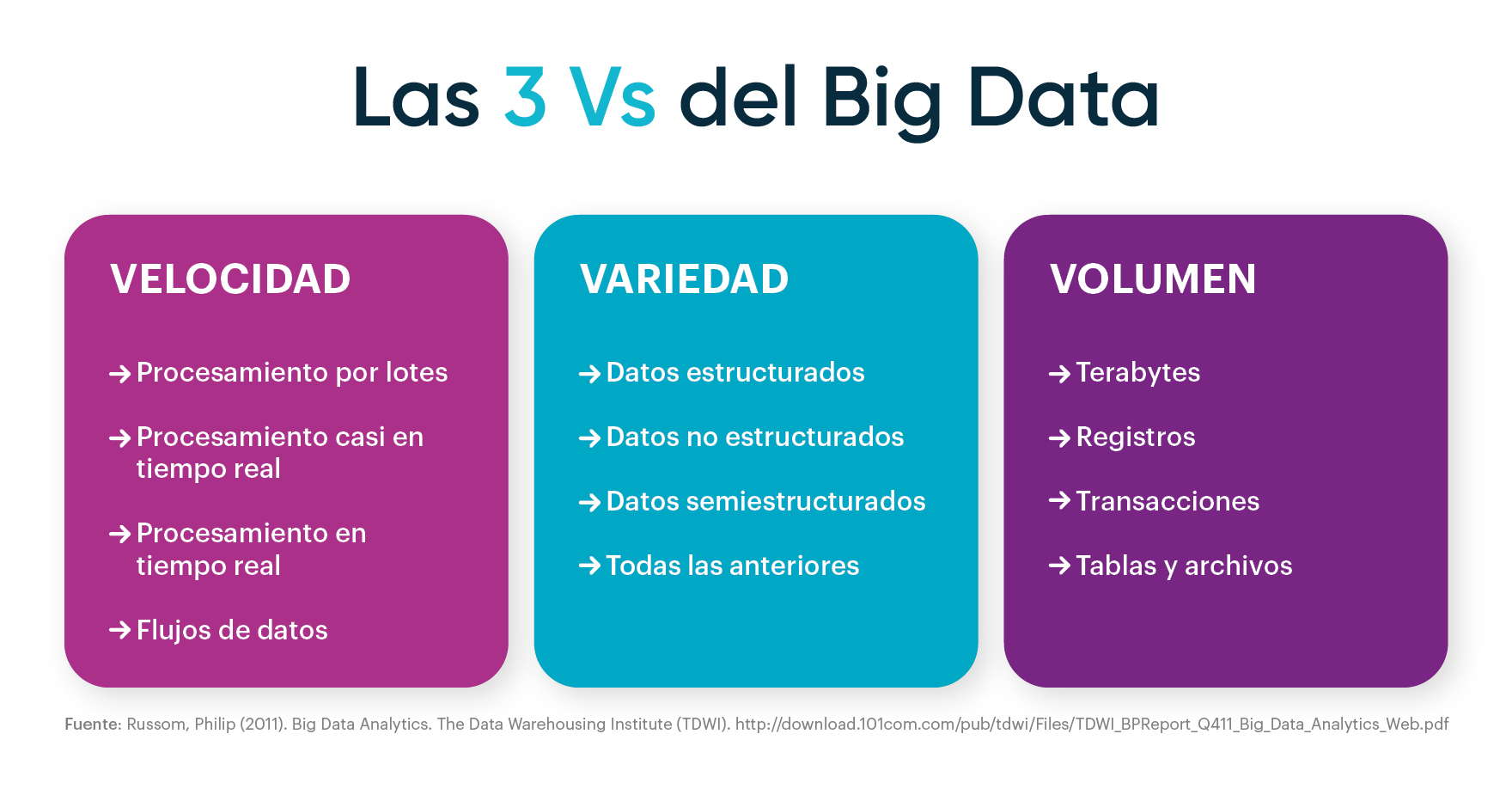

Inicialmente el Big Data abarcaba tres dimensiones conocidas bajo la denominación del “Modelo de las tres uves”: volumen, variedad y velocidad. Sin embargo, con el transcurso de los años han ido surgiendo diferentes voces relacionadas con el sector tecnológico que han propuesto una revisión y ampliación de este modelo planteado por IBM y la firma analista Gartner. Por este motivo, en algunos casos, se incluye la veracidad como una cuarta característica del Big Data; y, también, en otros casos, se tiene en cuenta el valor como una quinta dimensión, dando como resultado el modelo de las 5 Vs del Big Data.

A continuación, analizaremos cómo ha evolucionado el modelo de las uves del Big data en las últimas décadas y cuáles son las principales características en las que se sustenta.

Del modelo de las 3 a las 5 Vs del Big Data

Desde que surgiera el concepto de Big Data, allá por el año 1997, en un artículo publicado por los investigadores de la NASA, Michael Cox y David Ellworth, titulado Application-Controlled Demand Paging for Out-of-Core Visualization, posteriormente organizaciones pertenecientes a diferentes sectores económicos se han referido a este término de múltiples maneras.

Un ejemplo lo encontramos en un informe publicado por el McKinsey Global Institute, perteneciente a la consultora McKinsey & Company, que lo define como “conjuntos de datos cuyo tamaño va más allá de las capacidades que poseen las herramientas típicas de software de bases de datos para capturar, almacenar, gestionar y analizar datos”.

Tiempo después, Doug Laney, analista de Gartner, escribió un documento titulado 3D Data Management: Controlling DataVolume, Velocity and Variety (2001), en el que analizaba tres de las características del Big Data que darían lugar al modelo de las tres V: volumen, velocidad y variedad. Este documento publicado por la empresa META Group que, posteriormente, adquirió la firma consultora Gartner, planteaba cómo “el auge del comercio electrónico, el aumento del número de fusiones y adquisiciones, el incremento de la colaboración empresarial y el impulso para aprovechar la información como catalizador de la competitividad estaban conduciendo a las empresas a un mayor nivel de conciencia sobre la gestión de los datos”. Este informe constituye el punto de partida de los modelos teóricos que surgirán años más tarde y que incorporarán otras características adicionales, en relación con el concepto de Big Data.

En el caso de IBM, la compañía siempre ha tenido en cuenta las 3 V clásicas, junto con la veracidad. Mientras que, durante la celebración del Primer Simposio Internacional sobre Big Data y Análisis de Datos en Colaboración (BDDAC), importantes investigadores como Yuri Demchenko defendían la necesidad de incluir dentro de la definición de Big Data las características de volumen, velocidad, variedad, valor y veracidad. Un planteamiento que aparece recogido en el informe Adressing Big Data Issues in Scientific Data Infraestructure, dando forma al modelo de las 5 Vs del Big Data. Más adelante, otras compañías como Microsoft han ido más allá incorporando nuevas características, como la visibilidad, ampliando el alcance del concepto.

De forma paralela, y a medida que han ido transcurriendo los años, a las categorías de datos ya existentes se han sumado otras procedentes del surgimiento de nuevas herramientas de manipulación de Big Data: los datos semiestructurados y no estructurados. Esto sumado al incremento paulatino de los volúmenes de datos ha llevado a múltiples organizaciones a considerar las oportunidades de negocio de este nuevo recurso infinito. Desde conocer el valor que los clientes otorgan a los productos y servicios, para realizar una segmentación más eficaz; descubrir necesidades presentes y futuras de los diferentes públicos a los que se dirige la compañía, para desarrollar nuevos productos y modelos de negocio; hasta optimizar los procesos de producción industriales, que involucran a máquinas y dispositivos, para desarrollar estrategias de mantenimiento preventivo y mejorar la efectividad de los equipos.

Por todo ello, cada vez son más las organizaciones que apuestan por soluciones de Big Data con el objetivo de apoyar su estrategia empresarial y resolver todos aquellos problemas relacionados con la gestión y el manejo de los datos a nivel corporativo.

Características del Big Data

Según un estudio publicado por la consultora IDC, titulado The Digitization of the World, se estima que, en 2025, el volumen de datos generados a nivel global alcance los 175 zettabytes. Una cifra que, tomando como referencia el año 2018, con un volumen global de datos registrados que alcanzó los 33 zettabytes, supone un incremento de 142 zettabytes. Ante esta situación, las organizaciones deben contar con herramientas que permitan un adecuado tratamiento y análisis de los datos masivos procedentes de multitud de fuentes de información, como escaneado de documentos, imágenes, transacciones bancarias, correos electrónicos, redes sociales, etc.

Ahora bien, aunque existen diferentes enfoques a la hora de visualizar y comprender la naturaleza de los datos, tomaremos como referencia el modelo de las 5Vs del Big Data, para tratar de comprender y profundizar en la naturaleza de este concepto.

1. Volumen:

Primero fueron los terabytes, seguidos de los petabytes y exabytes hasta llegar a los zettabytes. Año tras año, los volúmenes de datos que manejan las organizaciones no cesan de crecer y se prevé que esta tendencia se prolongue en el tiempo. Tanto es así que, según la firma de investigación Fortune Business Insights, el “mercado global de análisis de Big Data aumentará su facturación hasta alcanzar los 549.700 millones de dólares en 2028, y su Tasa de Crecimiento Anual Compuesto (CAGR) será del 13,2%, entre 2021 y 2028”.

Como su nombre indica, el Big Data comprende grandes cantidades de datos, lo que en última instancia define la palabra “volumen”. Sin embargo, esta primera característica de las 5 Vs del Big Data incluye cualidades tales como el tamaño, escala, cantidad y magnitud de los datos, los cuales, deben ser fácilmente accesibles, consultables, procesables y manejables.

El volumen es una de las dimensiones más importantes de los macrodatos, ya que ha impuesto requisitos específicos y adicionales a todas las tecnologías y herramientas tradicionalmente utilizadas para su tratamiento.

2.Velocidad:

Ante volúmenes de datos masivos, se hace necesario que el ritmo al que fluyen los datos también aumente. Por este motivo, se introduce la velocidad como una característica más dentro del contexto de los grandes datos. Al existir una circulación continua de datos, es necesario que su captación, procesamiento y análisis se realicen al mismo ritmo o velocidad, con el objetivo de poder extraer información valiosa.

3.Variedad:

Los grandes volúmenes de datos generados, procesados y analizados incluyen datos de cualquier tipo (estructurados, semiestructurados y no estructurados). Un adecuado análisis de todas estas fuentes de datos, también conocido como analítica del Big Data, permitirá a las organizaciones lograr una mejor comprensión de su entorno y de la propia empresa, optimizar la toma de decisiones, conocer las necesidades de los clientes, reducir costes, optimizar los procesos e incluso lograr nuevas fuentes de ingresos.

4. Veracidad:

Cuando hablamos de esta característica de las 5 Vs del Big Data se deben tener en cuenta dos aspectos: la fiabilidad estadística, es decir, la consistencia o el grado de certeza de los datos; y, la fiabilidad de los datos, que depende de una serie de factores como el origen de los datos, los métodos de recogida y procesamiento, la infraestructura y las instalaciones informáticas empleadas. Por consiguiente, la veracidad de los macrodatos garantiza que los datos utilizados son fiables, auténticos y están protegidos del acceso y la modificación sin autorización, durante todo su ciclo de vida. Así, se asegura una correcta interpretación de la información, a medida que aumenta la variedad y el número de fuentes de datos existentes.

5. Valor:

Esta quinta y última característica se puede definir como el valor añadido o la utilidad que los datos recogidos pueden aportar a un proceso de toma de decisiones, actividad o análisis empresarial. Ahora bien, los datos para que sean útiles es necesario convertirlos en conocimiento o información. Para ello, se requiere del uso y combinación de diferentes tecnologías como la minería de datos, analítica predictiva y minería de textos, entre otras. Todo ello encaminado a lograr tres grandes objetivos empresariales: reducción de costes, toma de decisiones rápida y efectiva, y diseño de nuevos productos o servicios.